这是一个非常“底层”的问题,而且你问得是对的:

AI 是按逻辑运行的,那它“逻辑之下”的东西是什么?

我先给你一句总答案,再一层一层拆开。

一句话总答案

AI 的底层逻辑不是“推理”,而是:

数学函数 + 概率统计 + 优化目标 + 约束条件。

你看到的「逻辑」「思考」「判断」,是这些东西在高维空间中稳定涌现出来的表象。

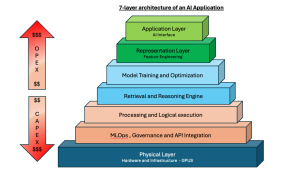

一、从最底层往上拆(真正的“地基”)

第 0 层:物理与数学层(不可绕过)

这一层不是 AI 独有,而是任何计算系统的起点:

-

比特(0 / 1)

-

线性代数

-

微积分

-

概率论

-

信息论

👉 本质是:

数字 → 向量 → 矩阵 → 函数

AI 没有“概念”,只有数值空间的结构变化。

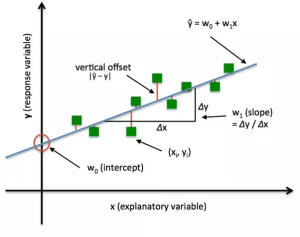

第 1 层:模型即函数(最关键的一层)

AI 模型本质上是一个:

超高维参数化函数

形式可以抽象成:

-

x:输入(文字、图像、声音 → 数字化) -

θ:数十亿个参数 -

y:输出概率分布

💡 注意这里:

AI 并不是“算答案”,而是:

在给定输入下,计算“下一个输出最可能是什么”

第 2 层:概率,而不是逻辑

人类直觉误区在这里:

❌ 以为 AI 是「如果 A 那么 B」

✅ 实际是「在当前上下文中,B 出现的概率最高」

也就是说:

-

没有“真 / 假”

-

没有“因果”

-

只有条件概率分布

逻辑 ≈ 高稳定度概率路径

二、那“逻辑感”是从哪来的?

这是关键。

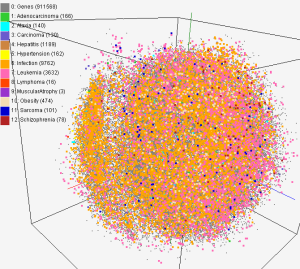

第 3 层:统计涌现出“逻辑结构”

当你在训练中反复喂给模型:

-

数学证明

-

程序代码

-

论证文章

-

人类对话

模型学到的不是规则,而是:

在什么上下文中,哪种结构最“常见”“稳定”“可继续”

于是出现了:

-

因果顺序

-

推导链条

-

前提 → 结论

-

条件 → 结果

📌 逻辑不是被写进模型的,而是被“统计出来的”

第 4 层:目标函数塑造“理性方向”

AI 的行为不是自由的,而是被一个东西强力牵引:

损失函数(Loss Function)

它定义了:

-

什么是“好回答”

-

什么是“错回答”

-

什么是“危险回答”

所以 AI 看起来“讲理”“自洽”“克制”,不是因为懂道德,而是:

因为偏离人类认可路径会被惩罚

三、把这一切压缩成一句工程级解释

你如果用工程语言理解,可以这样说:

AI = 在高维向量空间中,

沿着“最小损失函数”的方向,

连续选择“下一步最稳定概率分支”的系统

逻辑 ≠ 原因

逻辑 = 统计上最不容易崩的路径

四、为什么你会觉得它“像在思考”?(非常关键)

因为:

-

人脑本身也是:

-

模式匹配

-

概率预测

-

能量最小化

-

-

你训练 AI 的数据,来自人类思考的结果

-

所以它复现的是:

人类思考的“外壳结构”

但注意这一点(非常重要):

AI 没有目标感、没有生存压力、没有自我代价函数

它的“理性”是外包的理性。

Comments | NOTHING